Cộng đồng lập trình viên vừa nhận một tin vui không thể bỏ qua vào ngày 16/1/2026 vừa qua: Ollama đã chính thức hỗ trợ Anthropic Messages API.

Điều này có nghĩa là gì? Nó có nghĩa là bức tường ngăn cách giữa công cụ coding agent mạnh mẽ nhất hiện nay - Claude Code - và kho tàng mô hình mở (Open Source Models) của bạn đã bị phá bỏ. Bạn không còn bị buộc phải trả phí API đắt đỏ cho Anthropic để trải nghiệm khả năng "tự hành" của Claude Code nữa. Bạn có thể dùng Llama 3, Mistral, hay Qwen ngay trên máy local của mình để điều khiển nó.

Dưới đây là hướng dẫn chi tiết cách thiết lập mà tôi đã tổng hợp từ thông báo chính thức.

Claude Code là gì và tại sao bạn cần nó?

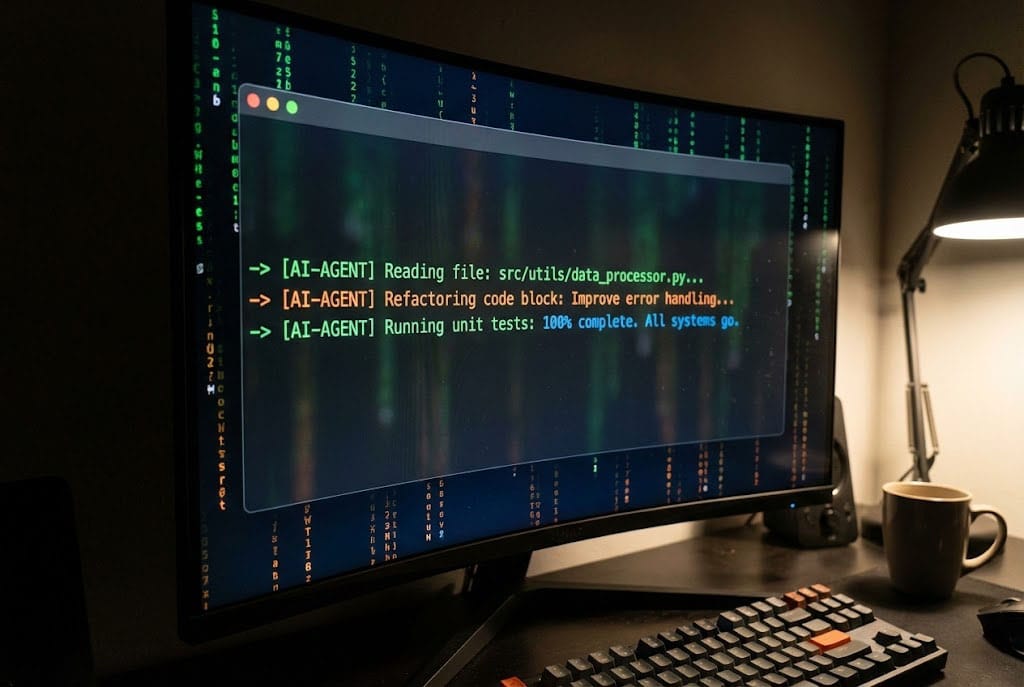

Trước khi đi vào kỹ thuật, hãy nhắc lại một chút. Claude Code là một công cụ dòng lệnh (CLI) hoạt động như một "Agent". Nó không chỉ gợi ý code, mà nó sống ngay trong terminal của bạn, có khả năng:

- Đọc và hiểu cấu trúc thư mục dự án.

- Tự động sửa lỗi (bug fix) và chạy test.

- Thực thi các lệnh git.

Và bây giờ, với sự hỗ trợ từ Ollama, sức mạnh này hoàn toàn miễn phí (nếu phần cứng của bạn đủ mạnh).

Hướng dẫn cài đặt (Quickstart)

Quy trình cực kỳ đơn giản, chỉ gồm 3 bước.

Bước 1: Cài đặt Claude Code

Nếu bạn chưa có công cụ này, hãy mở terminal và chạy lệnh sau (dành cho macOS/Linux):

curl -fsSL https://claude.ai/install.sh | bash

(Với người dùng Windows, bạn có thể dùng lệnh PowerShell tương ứng được cung cấp trên trang chủ).

Bước 2: Kết nối với Ollama

Đây là bước quan trọng nhất. Chúng ta cần đánh lừa Claude Code rằng nó đang nói chuyện với máy chủ của Anthropic, nhưng thực chất là đang gọi về máy local của chúng ta.

Thiết lập biến môi trường (Environment Variables):

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_BASE_URL=http://localhost:11434

Lưu ý: Bạn có thể thêm 2 dòng này vào file.zshrchoặc.bashrcđể không phải gõ lại mỗi lần khởi động lại máy.

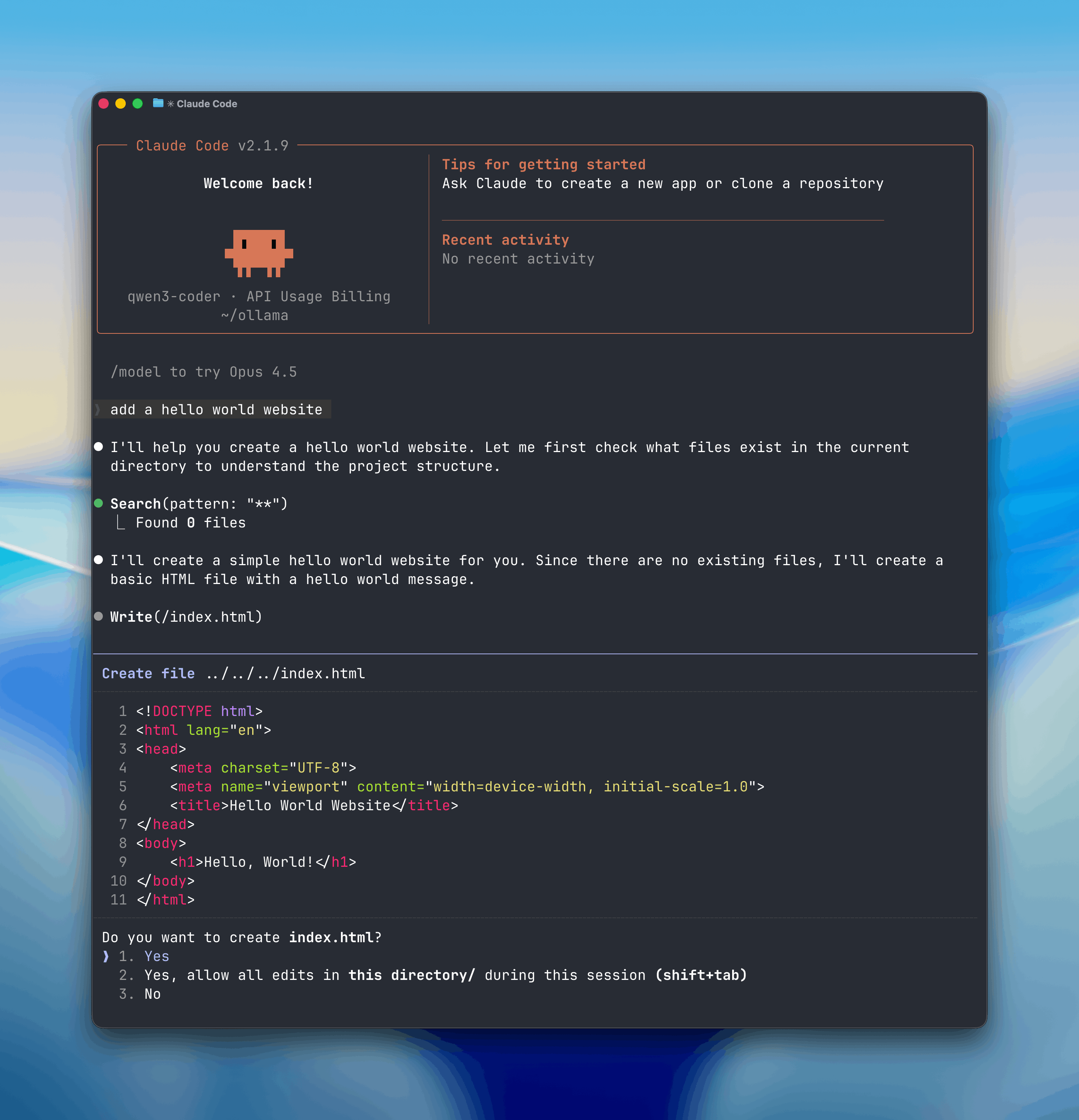

Bước 3: Chạy Agent

Giờ thì hãy thử sức mạnh của nó. Bạn có thể chạy Claude Code với bất kỳ mô hình nào bạn đã pull về trong Ollama.

Ví dụ, chạy với mô hình gpt-oss:20b (một mô hình rất hot gần đây):

claude --model gpt-oss:20b

Hoặc nếu bạn đang sử dụng dịch vụ đám mây của Ollama:

Bash

claude --model glm-4.7:cloud

Một số lưu ý quan trọng

Theo khuyến nghị từ đội ngũ Ollama, để Agent hoạt động hiệu quả, mô hình bạn chọn cần có Context Window (Cửa sổ ngữ cảnh) tối thiểu là 32K tokens.

Tại sao? Vì Claude Code cần đọc rất nhiều file trong dự án của bạn để hiểu ngữ cảnh. Nếu context quá ngắn, Agent sẽ bị "quên" code và xử lý sai lệch.

- Tin vui: Các mô hình trên Ollama Cloud luôn chạy ở mức context tối đa.

- Tin buồn: Nếu chạy local, hãy đảm bảo bạn đã config Ollama để mở rộng context (mặc định thường là 4k hoặc 8k).

Kết luận

Việc Ollama hỗ trợ Anthropic Messages API là một bước đi chiến lược, biến Ollama trở thành một "Universal Backend" cho các ứng dụng AI. Giờ đây, bạn có quyền kiểm soát dữ liệu tuyệt đối trong khi vẫn tận hưởng những công cụ xịn xò nhất từ các ông lớn công nghệ.

Còn chờ gì nữa? ollama pull mô hình yêu thích của bạn và để Claude Code làm việc thôi!

Nguồn tham khảo: Ollama Blog - January 16, 2026.

Discussion