Tin vui cho anh em hay chạy AI trên máy mình!

LM Studio vừa drop bản 0.4.0 vào ngày 28/01/2026 - và lần này họ làm lại gần như mọi thứ. Parallel requests, headless server, UI mới... Đây là bản cập nhật lớn nhất từ trước đến giờ.

Mình vừa upgrade xong và phải nói thật là khác biệt khá rõ. Cùng xem có gì hay ho nhé!

🆕 Có Gì Mới Trong 0.4.0?

Tóm tắt nhanh

| Tính năng | Trước đây | 0.4.0 |

|---|---|---|

| Xử lý requests | Xếp hàng (queue) | Parallel + continuous batching |

| Chạy không GUI | Không được | ✅ llmster daemon |

| llama.cpp | 1.x | 2.0.0 |

| API | OpenAI compatible | + Stateful REST API mới |

| Deploy | Chỉ desktop | Cloud, CI, Colab... |

Đây không phải update nhỏ - họ đã rearchitect toàn bộ software.

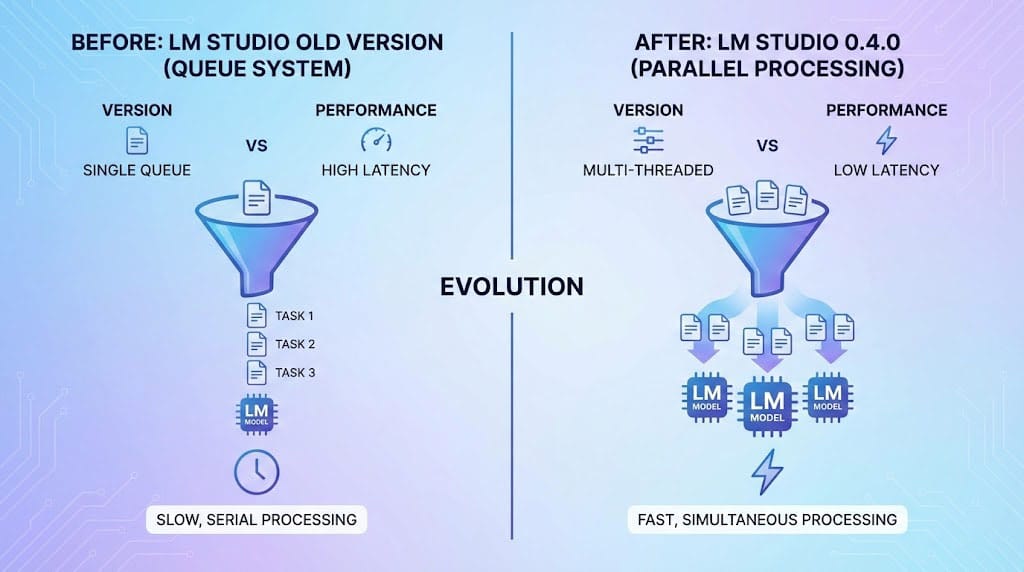

⚡ Parallel Requests - Xử Lý Song Song

Đây là thay đổi lớn nhất.

Trước đây:

- Mỗi request phải xếp hàng chờ

- Request thứ 2 đợi request thứ 1 xong

- Bottleneck khi nhiều người dùng

Bây giờ:

- Continuous batching - nhiều requests xử lý cùng lúc

- Throughput cao hơn đáng kể

- Model serve được nhiều clients

Trước: Request 1 → [Processing] → Done → Request 2 → [Processing] → Done

Sau: Request 1 → [Processing ████████████] → Done

Request 2 → [Processing ████████████] → Done

Request 3 → [Processing ████████████] → Done

(Chạy đồng thời!)

Điều này quan trọng nếu bạn dùng LM Studio làm backend cho app, hoặc có nhiều người trong team cùng query một model.

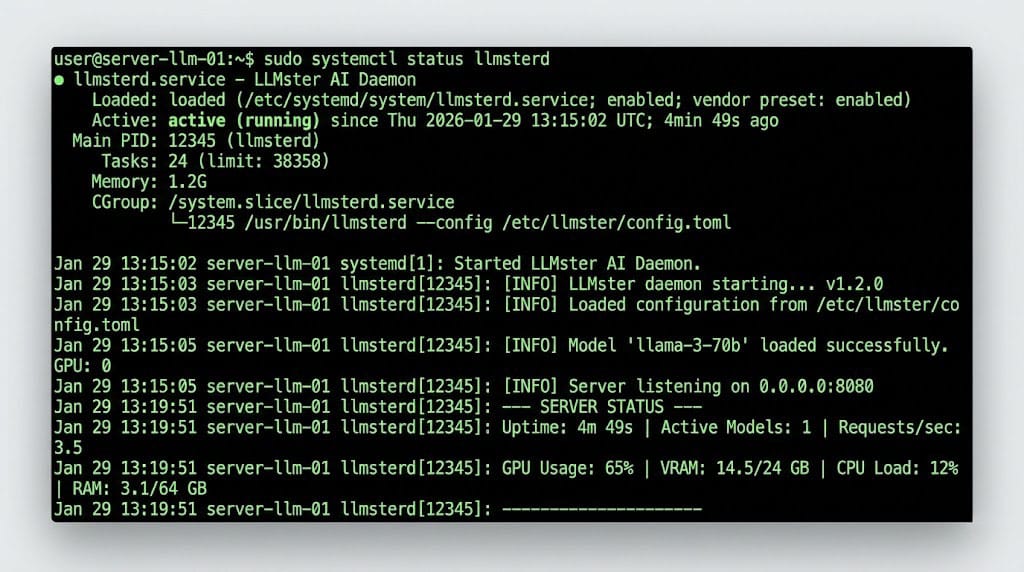

🖥️ llmster - Chạy Headless Không Cần GUI

Đây là tính năng mình thích nhất.

LM Studio giờ tách core engine thành tool riêng gọi là llmster - có thể chạy như daemon mà không cần mở app.

Use cases:

- Deploy trên cloud server (không có màn hình)

- Chạy trong CI/CD pipelines

- Cài trên GPU rig remote

- Dùng trong Google Colab

Cách sử dụng

# Khởi động daemon

lms daemon up

# Check status

lms status

# Chat qua CLI

lms chat

📖 Chi tiết tại CLI Documentation

CLI mới còn có slash commands - gõ / để xem các options.

🔧 llama.cpp Engine Upgrade

LM Studio upgrade lên phiên bản llama.cpp mới - đây là engine inference quan trọng nhất cho local LLM.

Những cải tiến:

- Faster inference

- Better memory management

- Hỗ trợ models mới hơn

- Continuous batching support

Nếu bạn dùng các models như Qwen3, Gemma3, hay DeepSeek - chúng sẽ chạy mượt hơn trên engine mới.

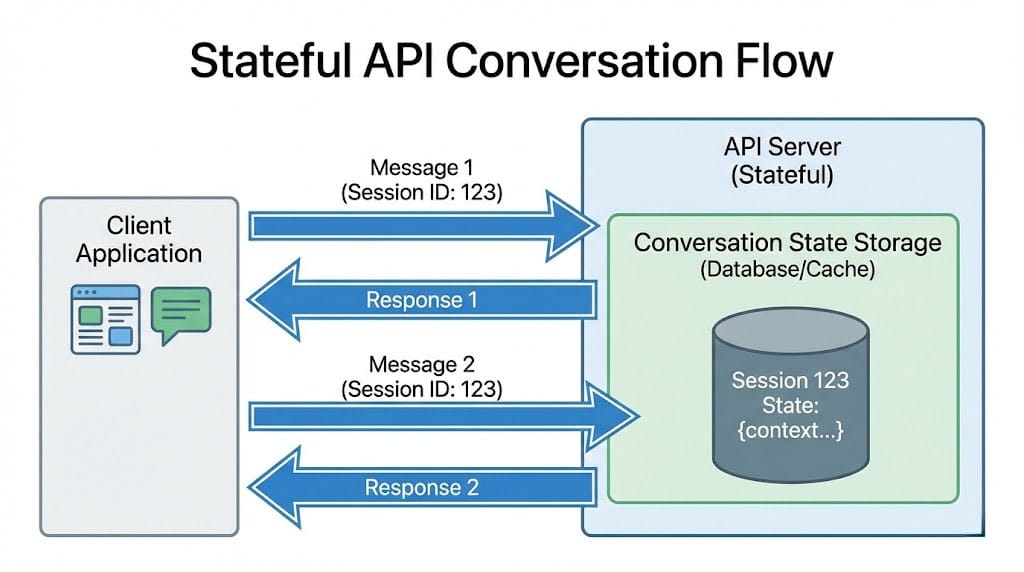

🔌 API Mới - Stateful REST

Ngoài OpenAI-compatible API cũ, giờ có thêm:

/v1/chat - Stateful Endpoint

import requests

# Tạo conversation mới

response = requests.post("http://localhost:1234/v1/chat", json={

"messages": [{"role": "user", "content": "Hello!"}],

"model": "your-model"

})

# Response giữ conversation state

conversation_id = response.json()["conversation_id"]

# Tiếp tục conversation

response = requests.post("http://localhost:1234/v1/chat", json={

"conversation_id": conversation_id,

"messages": [{"role": "user", "content": "Tell me more"}]

})

Ưu điểm:

- Không cần gửi full history mỗi request

- Server giữ context

- Tiết kiệm bandwidth

API cũ vẫn hoạt động, nên code hiện tại không bị break.

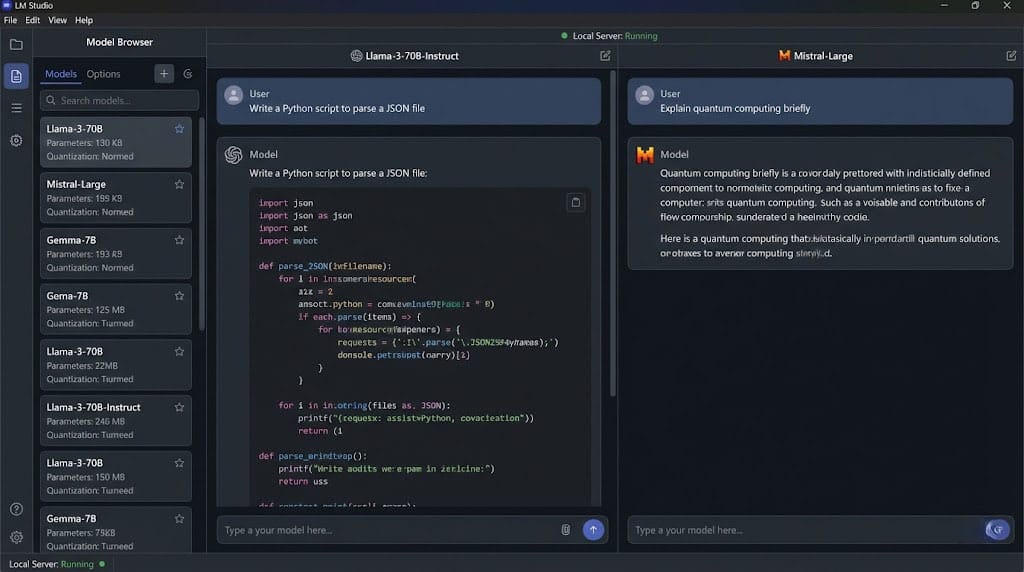

🎨 UI Mới Refreshed

Giao diện cũng được làm mới:

Tính năng mới

- Chat export - Xuất conversation ra file

- Split view - Xem nhiều chat cùng lúc

- Developer mode - Debug tools cho devs

- In-app docs - Documentation ngay trong app

Model browser cải tiến

- Tìm model nhanh hơn

- Preview model info trước khi download

- Quản lý local models dễ hơn

📋 Models Được Hỗ Trợ

LM Studio 0.4.0 hỗ trợ các model formats:

| Format | Ví dụ models |

|---|---|

| GGUF | LLaMA, Mistral, Mixtral |

| Qwen3 | Qwen3-7B, Qwen3-72B |

| Gemma3 | Gemma3-2B, Gemma3-9B |

| DeepSeek | DeepSeek-Coder, DeepSeek-V3 |

| GPT-OSS | Various open source GPT |

Với llama.cpp 2.0, nhiều models mới nhất đã được support ngay từ đầu.

🚀 Cách Cập Nhật

Option 1: Auto-update

Mở LM Studio → Check updates → Install

Option 2: Fresh install

Tải từ lmstudio.ai → Cài đè bản cũ

📖 Xem chi tiết tại Release Notes 0.4.0

Option 3: CLI (nếu đã có)

# Trên macOS/Linux

lms update

# Hoặc download installer mới

⚠️ Lưu ý: Backup settings trước khi upgrade nếu bạn có nhiều custom configs.

💡 Khi Nào Nên Dùng LM Studio?

Phù hợp nếu bạn:

- Muốn chạy AI privacy-first - data không đi đâu

- Có GPU đủ mạnh (RTX 3060+ khuyến nghị)

- Cần self-hosted API cho project

- Thích thử nghiệm nhiều models khác nhau

- Không muốn trả phí API cho OpenAI/Anthropic

Có thể chưa cần nếu:

- GPU yếu hoặc không có

- Chỉ dùng AI casual, API cloud đủ rồi

- Cần scale lớn (dùng cloud inference tốt hơn)

🆚 So Với Các Tool Khác

| Feature | LM Studio | Ollama | Text Gen WebUI |

|---|---|---|---|

| GUI | ✅ Đẹp | ❌ CLI only | ✅ Web-based |

| Parallel requests | ✅ 0.4.0 | ✅ | ✅ |

| Headless mode | ✅ llmster | ✅ Native | ⚠️ Limited |

| Ease of use | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐ |

| Model browser | ✅ Built-in | ❌ Manual | ⚠️ Basic |

| Cross-platform | ✅ Win/Mac/Linux | ✅ | ✅ |

LM Studio strongest point vẫn là ease of use - rất thân thiện với người mới.

⚠️ Những Điểm Cần Lưu Ý

1. RAM requirements (ước tính)

- 7B model: 8GB RAM minimum

- 13B model: 16GB RAM

- 70B model: 32GB+ RAM (hoặc quantized)

2. GPU VRAM

- Quan trọng hơn RAM cho speed

- 8GB VRAM chạy được 7B-13B models

- 24GB VRAM cho 70B models

3. Disk space

- Models khá nặng (3-40GB mỗi model)

- Chuẩn bị SSD với nhiều space

✅ Kết Luận

LM Studio 0.4.0 là bản cập nhật đáng giá:

- ✅ Parallel requests - throughput cao hơn nhiều

- ✅ llmster daemon - deploy headless dễ dàng

- ✅ llama.cpp 2.0 - engine mới mạnh hơn

- ✅ API mới - stateful REST endpoint

- ✅ UI refreshed - giao diện đẹp và tiện hơn

Nếu bạn đang chạy AI local, đây là lúc để upgrade. Parallel requests alone đã đáng để update rồi.

Download: lmstudio.ai

Bạn đang dùng LM Studio chưa? Model nào chạy hay nhất với setup của bạn? Share nhé! 💬

Discussion