Trong suốt năm 2023-2024, chúng ta đã chứng kiến cuộc đua "vũ trang" khốc liệt về quy mô tham số (parameters) của các mô hình ngôn ngữ lớn (LLMs). GPT-4, Gemini Ultra, Claude 3 Opus - những gã khổng lồ này càng lớn càng tốt.

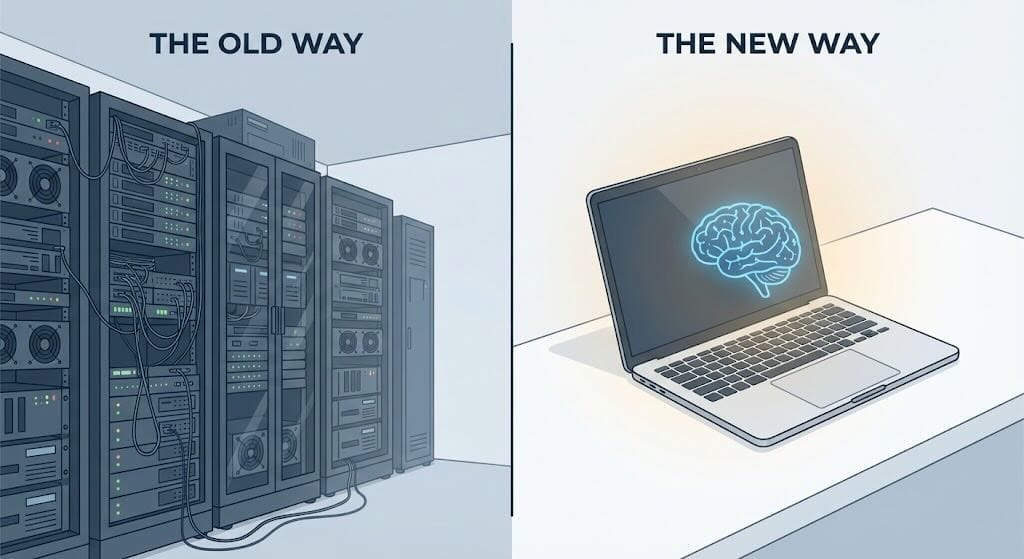

Tuy nhiên, bước sang 2025 và dự kiến bùng nổ trong 2026, gió đã đổi chiều. Xu hướng hiện tại không còn là "Bigger is Better" (Càng to càng tốt) mà là "Small is Smart" (Nhỏ mà thông minh). Thế giới công nghệ đang chuyển dịch mạnh mẽ sang các mô hình ngôn ngữ nhỏ (Small Language Models - SLMs) và việc chạy AI cục bộ (Local AI).

Tại sao lại có sự thay đổi này? Và làm thế nào để bạn bắt kịp xu hướng này ngay trên chiếc laptop của mình?

1. Tại sao SLM (Specialized Models) lại lên ngôi?

Sự thật là: Bạn không cần một giáo sư đại học để giải bài toán cộng trừ lớp 1.

Việc sử dụng một model 1000 tỷ tham số chỉ để tóm tắt email hay sửa lỗi ngữ pháp cũng lãng phí tài nguyên y như vậy. Các mô hình chuyên biệt (Specialized Models) ra đời để giải quyết bài toán hiệu quả năng lượng và chi phí, với những ưu điểm vượt trội:

- Hiệu suất/Chi phí tối ưu: Các model nhỏ như Microsoft Phi-4 (bản Mini), Google Gemma 3 hay Llama 3.2 (các phiên bản dưới 10B) có khả năng suy luận (reasoning) kinh ngạc, tiệm cận các model lớn nhưng chỉ tốn một phần nhỏ tài nguyên tính toán.

- Tốc độ phản hồi (Latency): Vì model nhẹ, tốc độ trả lời gần như tức thì, không còn cảnh ngồi nhìn con trỏ nhấp nháy chờ server phản hồi.

- Tính riêng tư (Privacy): Đây là yếu tố then chốt. Với SLM, dữ liệu của bạn ở lại trên máy của bạn. Không có chuyện upload báo cáo tài chính hay code nội bộ lên đám mây của bên thứ ba.

2. Local AI: Khi Laptop trở thành "AI Server" cá nhân

Chạy AI cục bộ (Local AI) là việc bạn tải model về và chạy trực tiếp trên phần cứng của mình (MacBook M-series, Laptop có GPU NVIDIA RTX, hoặc thậm chí là điện thoại cao cấp).

Lợi ích thực tế:

- Hoạt động Offline 100%: Bạn có thể code, viết content, phân tích dữ liệu ngay cả khi ngồi trên máy bay hoặc nơi không có internet.

- Bảo mật tuyệt đối: Như đã đề cập, dữ liệu không bao giờ rời khỏi máy.

- Không tốn phí thuê bao: Quên đi hóa đơn $20/tháng cho ChatGPT Plus hay Claude Pro nếu nhu cầu của bạn chỉ là các tác vụ hàng ngày.

Những cái tên đáng chú ý cho năm 2026:

- Bộ ba "Thần Sấm": Llama (Meta), Gemma (Google), và Phi (Microsoft) đang cạnh tranh khốc liệt ở phân khúc tác vụ nhẹ (< 10B tham số).

- Qwen & Mistral: Những đại diện từ Trung Quốc và Pháp cũng đang cung cấp các model open-source cực kỳ mạnh mẽ, đặc biệt là khả năng code và toán học.

3. Hướng dẫn nhanh: Tự chạy Local AI trong 5 phút

Nếu bạn nghĩ việc cài đặt AI phức tạp như cài Linux năm 2000, thì bạn đã lầm. Năm 2026, mọi thứ đơn giản như cài một app game.

Công cụ mình khuyên dùng: Ollama hoặc LM Studio.

(Ví dụ với Ollama trên macOS/Linux/Windows):

- Bước 1: Tải và cài đặt tại ollama.com.

- Bước 2: Mở Terminal.

- Bước 3: Gõ lệnh

ollama run llama3.2(hoặcphi4,gemma2). - Bước 4: Xong! Bạn đã có một trợ lý AI chạy mượt mà ngay trong dòng lệnh.

Tip: Nếu muốn giao diện chat đẹp như ChatGPT, bạn có thể cài thêm các front-end như Open WebUI hay dùng LM Studio để có giao diện trực quan hơn.

4. Kết luận: Chiến lược cho Developer & Doanh nghiệp

Thay vì cố gắng xây dựng một "siêu AI" làm được mọi thứ nhưng chậm chạp và tốn kém, chiến lược thông minh cho 2026 là kết hợp nhiều model nhỏ.

- Dùng LLM (trên Cloud) cho các tác vụ cần sáng tạo cao, kiến thức tổng quát rộng.

- Dùng SLM (Local) cho các tác vụ lặp lại, xử lý dữ liệu nhạy cảm, coding assistant và các ứng dụng realtime.

"Nhỏ nhưng có võ" - đó chính là tương lai của AI bền vững.

Discussion