Bạn có bao giờ nghĩ sẽ đến lúc cộng đồng dev có thể sử dụng một mô hình AI ngang tầm với GPT-4 hay Claude mà... hoàn toàn miễn phí?

Arcee.ai vừa biến điều đó thành hiện thực với Trinity Large - mô hình mã nguồn mở khủng nhất từ trước đến nay với 400 tỷ tham số.

Mình đã nghiên cứu kỹ và thú thật là khá ấn tượng. Cùng xem đây có phải "đối trọng" thực sự với Big Tech không nhé!

🤖 Trinity Large Là Gì?

Trinity Large là mô hình ngôn ngữ lớn (LLM) mã nguồn mở do Arcee.ai phát triển, ra mắt vào ngày 27/01/2026.

Thông số kỹ thuật

| Thông số | Giá trị |

|---|---|

| Tổng tham số | 400 tỷ (400B) |

| Tham số active/token | 13 tỷ (13B) |

| Kiến trúc | Sparse Mixture-of-Experts (MoE) |

| Số experts | 256 total, 4 active/token |

| Data huấn luyện | 17 trillion tokens |

| Synthetic data | 8+ trillion tokens |

| GPU sử dụng | 2048 NVIDIA B300 |

| License | Apache 2.0 |

Số liệu nhìn choáng ngợp, nhưng điều hay là kiến trúc Sparse MoE giúp model chỉ dùng 13B tham số cho mỗi token - nên chạy được trên phần cứng bình thường.

💡 Tại Sao Trinity Large Quan Trọng?

1. Mã nguồn mở thực sự

Khác với các mô hình "open" nhưng bị hạn chế license, Trinity Large dùng Apache 2.0 - bạn có thể:

- Sử dụng thương mại

- Modify và distribute

- Không cần xin phép Arcee

Điều này khác hẳn với LLaMA của Meta hay một số model "open" khác có nhiều ràng buộc.

2. Đối trọng với Big Tech

Trước giờ, muốn dùng model mạnh thì phải:

- Trả tiền API cho OpenAI, Anthropic, Google

- Phụ thuộc vào chính sách của họ

- Data gửi qua server của Big Tech

Trinity Large thay đổi cuộc chơi. Bạn có thể self-host hoàn toàn, data không đi đâu cả.

3. Chất lượng frontier-level

Arcee.ai không chỉ làm cho có. Họ train trên 17 trillion tokens, trong đó hơn 8 trillion là synthetic data chất lượng cao.

Theo benchmark đầu tiên, Trinity Large cạnh tranh được với các closed models trong nhiều task.

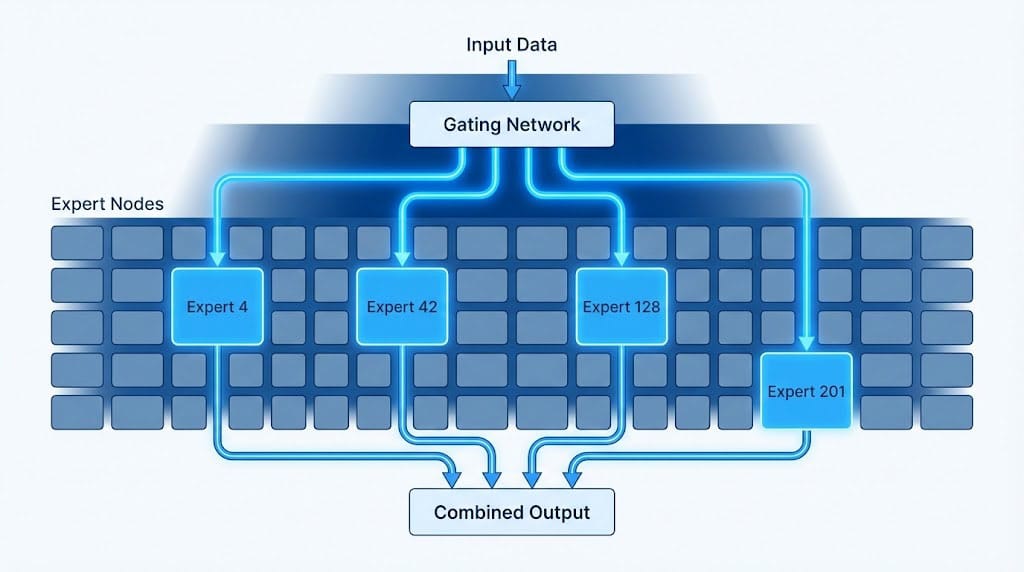

🔧 Kiến Trúc MoE - Tại Sao Lại "Sparse"?

Đây là phần kỹ thuật hay ho.

Mixture-of-Experts (MoE) hoạt động như sau:

- Model có 256 "experts" (sub-networks)

- Với mỗi token, chỉ 4 experts được activate

- Một "gating network" quyết định dùng experts nào

Ưu điểm:

- 400B params nhưng chỉ compute 13B → Nhanh hơn

- Mỗi expert "chuyên" một loại knowledge

- Scaling hiệu quả hơn dense models

Nhược điểm:

- Vẫn cần RAM để load toàn bộ weights

- Training phức tạp hơn

- Routing overhead

Input Token

↓

[Gating Network] → Chọn 4/256 experts

↓

Expert 1 + Expert 47 + Expert 128 + Expert 203

↓

Combine outputs

↓

Final Output

📦 Các Phiên Bản Trinity Large

Arcee.ai release 3 checkpoints từ cùng một quá trình training:

| Phiên bản | Mô tả | Use case |

|---|---|---|

| Trinity-Large-Preview | Chat-ready, light post-training | Dùng ngay, chat/assistant |

| Trinity-Large-Base | Full 17T tokens pretrained | Fine-tuning, custom training |

| Trinity-Large-TrueBase | 10T checkpoint pre-anneal | Research, experimentation |

Nếu bạn muốn thử ngay, dùng Preview - đã được instruction-tuned sẵn.

Nếu muốn fine-tune cho use case riêng, lấy Base hoặc TrueBase.

🚀 Cách Sử Dụng Trinity Large

Option 1: Dùng qua API (Nhanh nhất)

Arcee.ai cung cấp miễn phí qua OpenRouter:

import openai

client = openai.OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="your-openrouter-key"

)

response = client.chat.completions.create(

model="arcee-ai/trinity-large-preview",

messages=[

{"role": "user", "content": "Explain quantum computing simply"}

]

)

print(response.choices[0].message.content)

Option 2: Tải về từ HuggingFace

# Clone model (cần nhiều storage!)

git lfs install

git clone https://huggingface.co/arcee-ai/Trinity-Large-Preview

Option 3: Tích hợp với coding tools

Trinity Large đặc biệt mạnh với code. Các tool đã hỗ trợ:

- Kilo Code - Coding assistant

- Cline - VSCode extension

- OpenCode - CLI tool

💪 Trinity Large Mạnh Ở Đâu?

Theo Arcee.ai và early adopters:

Coding Excellence

Model giữ context tốt qua large codebases - quan trọng cho:

- Complex refactoring

- Architecture planning

- Multi-file changes

Reasoning

17T tokens training + synthetic data focus on reasoning → Strong performance trên các task logic.

Multilingual

Mặc dù chưa có benchmark chi tiết cho tiếng Việt, nhưng với lượng training data lớn, khả năng cao sẽ xử lý được.

⚠️ Hạn Chế Cần Biết

Công bằng mà nói, Trinity Large cũng có điểm cần lưu ý:

1. Hardware requirements

- Cần GPU với VRAM lớn để inference

- Quantization giúp ích nhưng có trade-off chất lượng

2. Còn mới

- Chưa có nhiều benchmark độc lập

- Community chưa đông bằng LLaMA ecosystem

3. Documentation

- Đang được build, chưa đầy đủ

- Best practices chưa rõ ràng

🆚 So Sánh Với Các Model Khác

| Model | Params | Open Source | Commercial Use | Self-host |

|---|---|---|---|---|

| Trinity Large | 400B MoE | ✅ Apache 2.0 | ✅ | ✅ |

| LLaMA 3.1 | 405B | ⚠️ Limited | ⚠️ Restrictions | ✅ |

| Mixtral | 8x22B | ✅ Apache 2.0 | ✅ | ✅ |

| GPT-4 | Unknown | ❌ | ✅ (API) | ❌ |

| Claude 3 | Unknown | ❌ | ✅ (API) | ❌ |

Trinity Large có lợi thế lớn về license tự do so với LLaMA, và về tính minh bạch so với closed models.

🎯 Ai Nên Dùng Trinity Large?

Nên thử nếu bạn:

- Đang build AI products và muốn full control

- Cần self-host vì data privacy

- Muốn fine-tune cho domain-specific

- Làm coding assistant/tools

Có thể chưa cần nếu:

- Chỉ dùng AI casual, API đủ rồi

- Không có GPU infrastructure

- Cần model đã được battle-tested

🔮 Ý Nghĩa Lớn Hơn

Mình nghĩ Trinity Large không chỉ là "thêm một model open source". Nó cho thấy:

1. Open source AI đang catch up nhanh

Cách đây 2 năm, gap giữa open và closed models rất lớn. Giờ thì khác.

2. Không nhất thiết phụ thuộc Big Tech

Enterprises giờ có lựa chọn thực sự - không cần gửi data qua OpenAI hay Anthropic.

3. Cộng đồng dev được trao quyền

Với Apache 2.0 license, bạn có thể build bất cứ gì mà không lo legal issues.

Arcee.ai tự gọi mình là "Open Intelligence Lab" - và với Trinity Large, họ đang chứng minh điều đó.

✅ Kết Luận

Trinity Large là bước tiến quan trọng cho cộng đồng AI mã nguồn mở:

- ✅ 400B parameters với kiến trúc MoE hiệu quả

- ✅ Apache 2.0 - tự do thương mại hoàn toàn

- ✅ Trained trên 17T tokens data

- ✅ Strong coding và reasoning capabilities

- ⚠️ Còn mới, cần thêm thời gian để community đánh giá

Nếu bạn đang xây dựng AI products và muốn thoát khỏi sự phụ thuộc vào Big Tech, Trinity Large đáng để thử.

Link hữu ích:

Bạn nghĩ sao về Trinity Large? Có kế hoạch dùng cho project nào không? Share với mình nhé! 💬

Discussion